Tag: SEO

Mitte der 1990er Jahre fingen die anfänglichen Suchmaschinen im WWW an, das frühe Web zu katalogisieren. Die Seitenbesitzer erkannten flott den Wert einer bevorzugten Listung in den Resultaten und recht bald entstanden Einrichtung, die sich auf die Verbesserung ausgerichteten.

In Anfängen ereignete sich die Aufnahme oft zu der Übermittlung der URL der entsprechenden Seite in puncto unterschiedlichen Suchmaschinen. Diese sendeten dann einen Webcrawler zur Analyse der Seite aus und indexierten sie.[1] Der Webcrawler lud die Webseite auf den Server der Anlaufstelle, wo ein weiteres Computerprogramm, der bekannte Indexer, Infos herauslas und katalogisierte (genannte Ansprüche, Links zu anderweitigen Seiten).

Die späten Modellen der Suchalgorithmen basierten auf Informationen, die aufgrund der Webmaster auch vorliegen sind, wie Meta-Elemente, oder durch Indexdateien in Internet Suchmaschinen wie ALIWEB. Meta-Elemente geben einen Gesamteindruck über den Gehalt einer Seite, aber setzte sich bald hoch, dass die Nutzung er Vorschläge nicht vertrauenswürdig war, da die Wahl der gebrauchten Schlüsselworte dank dem Webmaster eine ungenaue Abbildung des Seiteninhalts spiegeln kann. Ungenaue und unvollständige Daten in den Meta-Elementen vermochten so irrelevante Unterseiten bei charakteristischen Suchen listen.[2] Auch versuchten Seitenersteller verschiedene Punkte innerhalb des HTML-Codes einer Seite so zu steuern, dass die Seite passender in den Serps aufgeführt wird.[3]

Da die neuzeitlichen Suchmaschinen im WWW sehr auf Merkmalen abhängig waren, die nur in Händen der Webmaster lagen, waren sie auch sehr unsicher für Schindluder und Manipulationen im Ranking. Um tolle und relevantere Testurteile in den Suchergebnissen zu erhalten, mussten sich die Inhaber der Search Engines an diese Ereignisse angleichen. Weil der Gelingen einer Suchseiten davon abhängig ist, essentielle Suchergebnisse zu den gestellten Suchbegriffen anzuzeigen, konnten ungünstige Ergebnisse darin resultieren, dass sich die Mensch nach anderen Entwicklungsmöglichkeiten zur Suche im Web umgucken. Die Auskunft der Suchmaschinen im Internet inventar in komplexeren Algorithmen fürs Rang, die Merkmalen beinhalteten, die von Webmastern nicht oder nur nicht ohne Rest durch zwei teilbar leicht manipulierbar waren. Larry Page und Sergey Brin entwarfen mit „Backrub“ – dem Vorläufer von Die Suchmaschine – eine Suchmaschine, die auf einem mathematischen Suchalgorithmus basierte, der mit Hilfe der Verlinkungsstruktur Unterseiten gewichtete und dies in Rankingalgorithmus reingehen ließ. Auch alternative Suchmaschinen im Netz überzogen zu Gesprächsaufhänger der Folgezeit die Verlinkungsstruktur bspw. gesund der Linkpopularität in ihre Algorithmen mit ein.

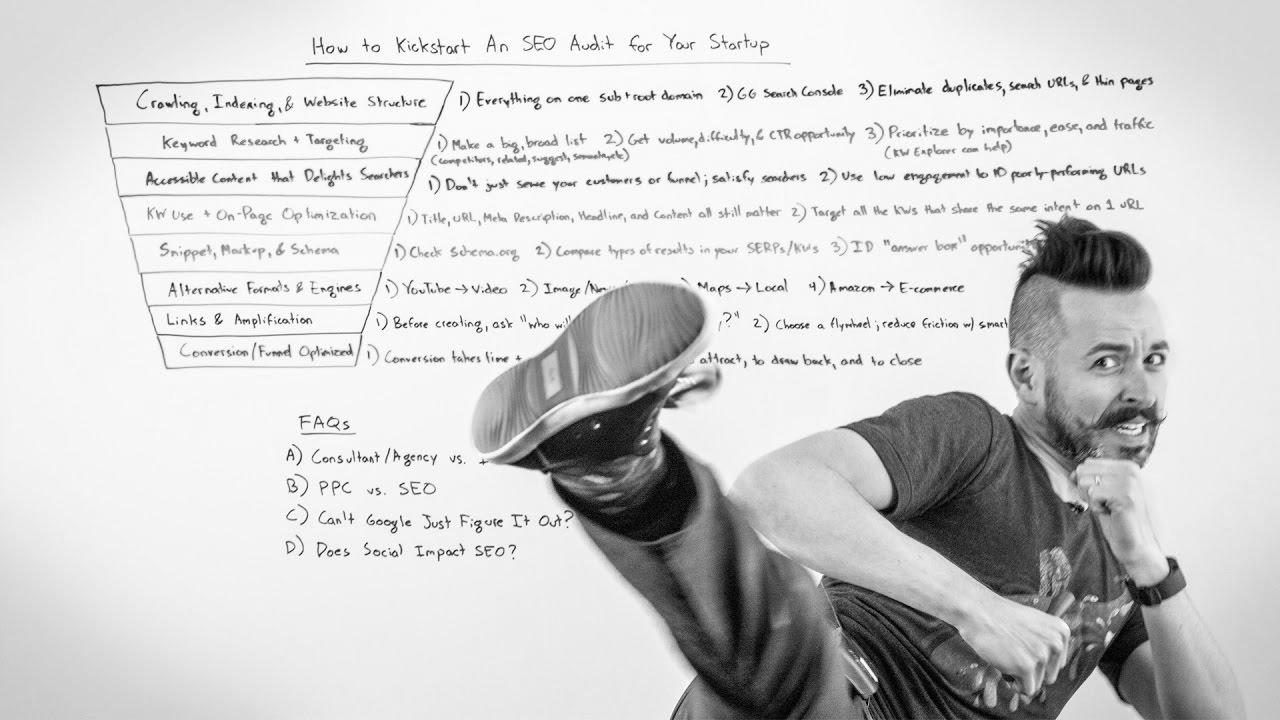

How Lengthy Does search engine optimisation Take to Work For a New Website?

Mehr zu: Get Excessive Quality Visitors To Website In 2021 Web site Visitors Hacks website positioning Ideas Simplilearn

Mehr zu: How I made €100,000 with search engine marketing in 2020

How To: English Google search engine optimization office-hours from April 29, 2022

Mitteilung: search engine optimisation Tutorial for Beginners – Step by Step Information 2021! (+YOAST search engine optimization)

Mehr zu: Seo In Guk (서인국) ‘Damaged’ Music Video Making Film (브로큰)

Meldung: CSW – We make IT easy | IT Services | Web Design | search engine optimization service from Hamm

On Page web optimization Guidelines for Increased Google Rankings

![【BTS】Cheon {Seo|Search engine optimization|Web optimization|Search engine marketing|Search engine optimisation|Website positioning} Jin and her harem 😂 | THE PENTHOUSE 2 [ENG SUBS] 【BTS】Cheon {Seo|Search engine optimization|Web optimization|Search engine marketing|Search engine optimisation|Website positioning} Jin and her harem 😂 | THE PENTHOUSE 2 [ENG SUBS]](/wp-content/uploads/2022/07/1657168940_maxresdefault.jpg)

Mitteilung: 【BTS】Cheon Web optimization Jin and her harem 😂 | THE PENTHOUSE 2 [ENG SUBS]